반응형

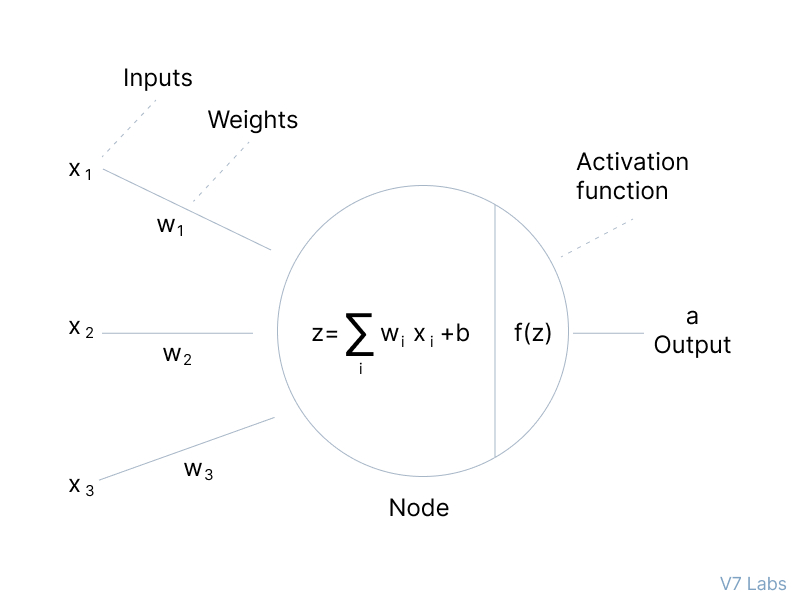

신경망에서 노드에 들어오는 입력은 가중치와 편향을 사용하여 선형 변환이 수행되고, 변환된 결과가 바로 다음으로 전달되는 것이 아닌 활성화함수를 적용하여 전달됨

활성화함수는 입력 신호를 출력 신호로 변환해주며, 입력 받은 신호의 출력 정도를 결정하고 딥러닝에서 층을 쌓아 비선형성을 표현할 수 있게 함

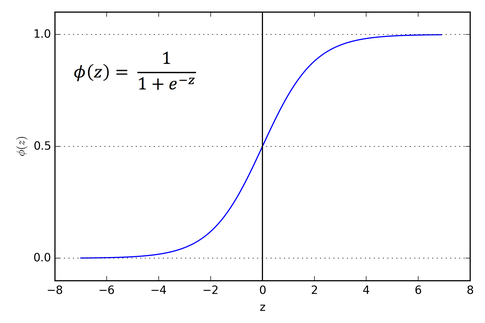

Sigmoid

시그모이드 활성화 함수의 출력은 0<y<1의 범위를 가지며 미분 가능함

이진 분류 문제에서 자주 사용됨

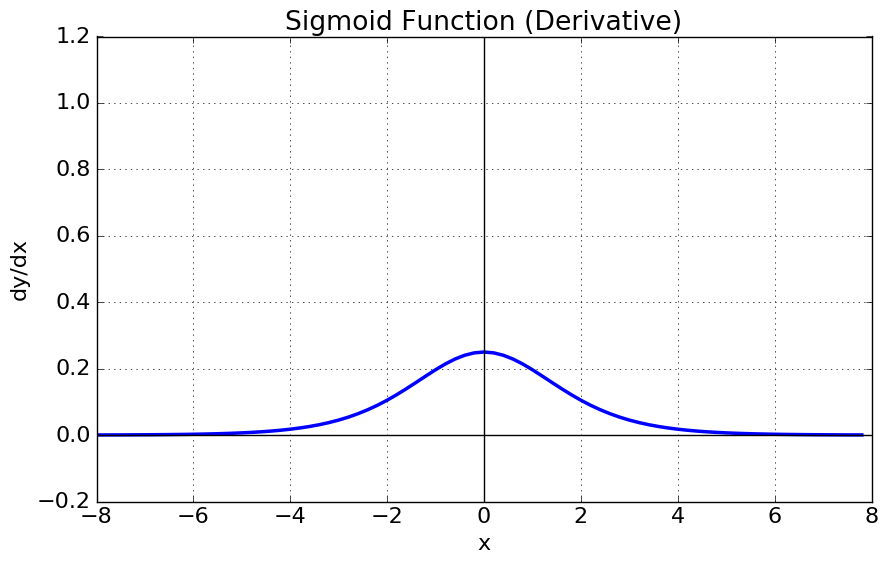

미분 함수에 대해서 x = 0에서 최대값 0.25를 가지며, 입력값이 일정 이상 올라가면 미분값이 0에 수렴

x의 값이 커질수록 미분값이 소실될 가능성이 커지는 Vanishing Gradient 문제가 있음

시그모이드 함수의 결과는 항상 양수이기에 역전파 과정에서 지그재그 형태로 학습되게 하고 학습을 오래 걸리게 함

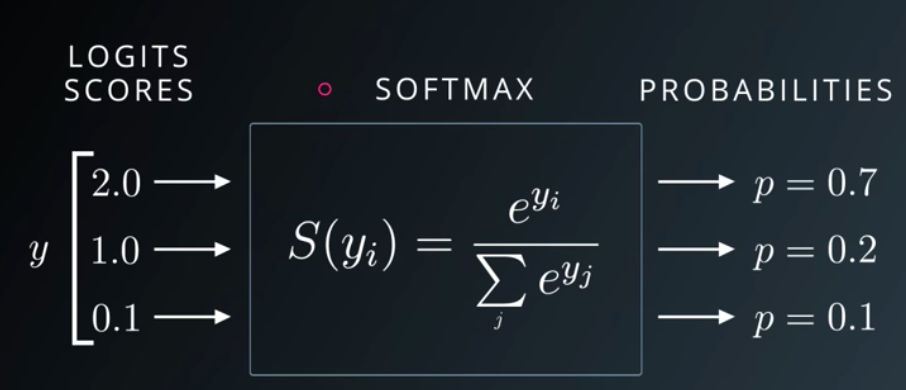

Softmax

소프트맥스의 출력은 0<y<1 사이 정규화된 값이며, 출력값들의 총 합은 항상 1

다중 분류 문제에서 주로 사용됨

확률값을 반환하는 점에서 시그모이드와 유사하나 시그모이드의 결과는 서로 독립적이기에 다중 분류에 적합하지 않음

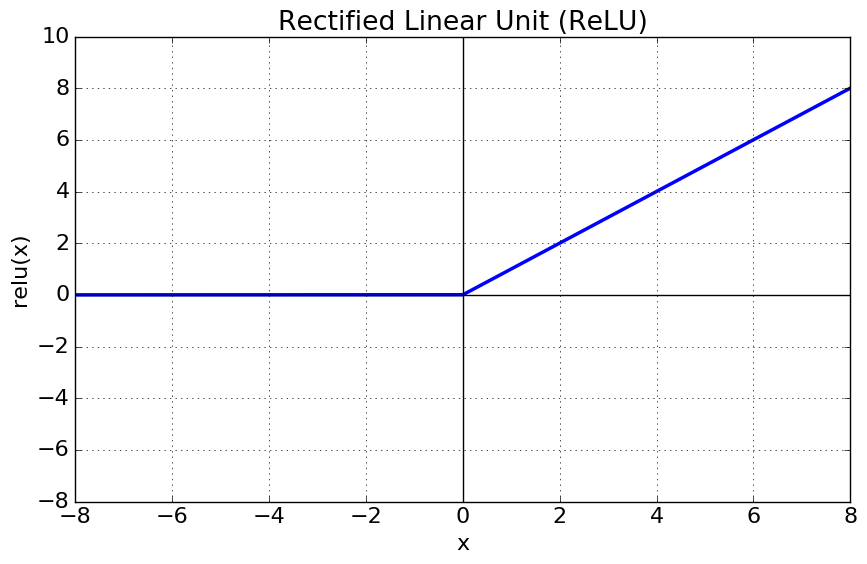

Relu

입력이 0 이상일 경우 기울기가 1인 직선, 0 이하일 경우 0을 반환

다른 활성화 함수에 비해 연신 비용이 작으며 구현이 간단

입력이 0 이하인 값에 대해서는 기울기가 0이기에 뉴런이 죽을 수 있는 단점 존재

- Leaky Relu

0이하의 값에서 뉴런이 죽는 현상 해결을 위해 0 이하 입력에 대해 매우 작은 기울기 적용

반응형

'Machine Learning > Theory' 카테고리의 다른 글

| 경사 하강법 최적화 알고리즘 - 1 (0) | 2023.09.13 |

|---|---|

| 경사하강법 (Gradient Descent) (0) | 2023.09.13 |

| 딥러닝 모델의 학습 (0) | 2023.09.13 |

| 오차 함수 종류 (0) | 2023.09.13 |